深度学习残差网络ResNet核心原理与架构解析

本文将详细介绍深度学习中的经典模型——残差网络(ResNet)。

1. 核心问题:为什么需要ResNet?

在ResNet出现之前,深度学习领域有一个直觉性的共识:网络越深(层数越多),性能应该越好。因为更深的网络可以学习到更复杂、更抽象的特征。

然而,实验发现,当网络深度增加到一定程度(例如超过20层)后,会面临两个主要问题:

1、梯度消失/爆炸:在反向传播过程中,梯度会随着层数的增加而指数级地减小或增大,导致浅层的网络权重无法有效更新。

注意:这个问题很大程度上可以通过*归一化初始化(如Xavier初始化)和归一化层(如Batch Normalization)来缓解。

2、网络退化:这是ResNet要解决的核心问题。即使在梯度问题被解决后,实验发现,更深的网络在训练集和测试集上的表现反而都比更浅的网络要差。这不仅仅是过拟合,因为它在训练集上的误差也更高了。

“网络退化” 现象表明:更深的网络并没有更容易地学习到“恒等映射”(即输出等于输入),而恒等映射对于一个深层网络来说,至少应该能做到和浅层网络一样好。

2. ResNet的核心思想:捷径连接

ResNet的作者何恺明等人提出了一个革命性的想法:既然直接让网络学习一个复杂的映射H( x )很困难,那么我们不如让它学习这个映射与输入x之间的“残差”。

他们重新定义了网络需要学习的目标。假设期望的底层映射为 ( H( x ) ),我们让堆叠的非线性层去拟合另一个映射:

[ F( x ) = H( x ) - x ]

那么,原始的映射就被转换为了:

[ H( x ) = F( x ) + x ]

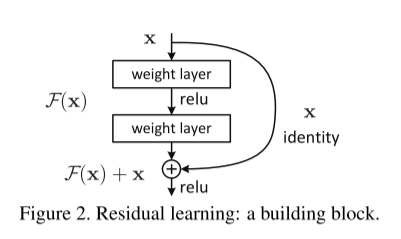

这个思想如下图所示:

这个 “+ x” 的操作就是捷径连接,也叫跳跃连接。它直接将输入x“抄近道”跳过了若干层(在ResNet中通常是2层或3层),与这些层的输出 ( F( x ) ) 进行逐元素相加。

3. 残差块的结构

ResNet是由多个残差块 堆叠而成的。最基本的残差块(针对ResNet-34及更浅的模型)结构如下:

1、数据流过两个卷积层(通常伴有Batch Normalization和ReLU激活函数)。

2、同时,输入x通过一条捷径直接跳接到第二个卷积层之后。

3、将捷径传来的x与卷积层的输出 ( F( x ) ) 进行逐元素相加。

4、将相加后的结果再通过一个ReLU激活函数输出。

公式表达为:

[ y = F( x, {W_i}) + x ]

[ out = ReLU( y) ]

当输入和输出的维度不一致时(例如,下采样时特征图尺寸减半、通道数翻倍),捷径连接需要执行一个线性投影来匹配维度。此时,捷径部分会通过一个1x1的卷积核进行运算:

[ y = F(x, {W_i}) + W_s x ]

[ out = ReLU( y) ]

其中 ( W_s ) 是1x1卷积的权重。

4. 为什么ResNet如此有效?

1、缓解梯度消失:梯度在反向传播时,除了可以通过卷积层传递,还可以通过捷径连接这条“高速公路”直接传回浅层。这极大地缓解了梯度消失问题,使得训练成百上千层的网络成为可能。

2、简化学习目标:网络不再需要学习一个完整的复杂输出 ( H( x ) ),而只需要学习输出与输入之间的残差 ( F( x ) )。如果某个层是冗余的,我们只需要简单地将它的权重推向零(( F( x ) \rightarrow 0 )),那么这个残差块就变成了一个恒等映射 ( H( x ) = x )。这使得训练深层网络变得非常简单和高效。

3、特征复用:捷径连接保护了信息的完整性,允许原始特征信息无障碍地向前传播,促进了不同层次特征的重用。

5. 经典的ResNet架构

ResNet论文提出了几种不同深度的版本,如ResNet-18, ResNet-34, ResNet-50, ResNet-101, ResNet-152。其中的数字代表的是带权重的层数。

1、ResNet-34及以下:使用基本残差块(两个3x3卷积层)。

2、ResNet-50及以上:使用瓶颈残差块,结构为1x1 -> 3x3 -> 1x1。

第一个1x1卷积用于降维,减少计算量。

第二个1x1卷积用于升维,恢复通道数。

这种设计在保持甚至提升性能的同时,大幅减少了参数和计算量。

所有版本都遵循类似的设计模式:开始时是一个普通的卷积和池化层,然后是4个阶段(每个阶段由多个残差块组成),每个阶段结束后特征图空间尺寸减半、通道数翻倍,最后是一个全局平均池化层和一个全连接层用于分类。

6. 影响与意义

1、历史性突破:ResNet在2015年的ImageNet竞赛中一举夺冠,将错误率降低到了3.57%,超越了人类的识别水平。它彻底解决了深度网络的训练难题。

2、推动深度学习发展:使得构建和训练成百上千层的超深度网络成为常态,催生了许多更强大的模型。

3、成为基础构建块:ResNet及其思想已经成为计算机视觉乃至其他深度学习领域(如NLP、语音识别)最基础和最重要的架构组件之一。后续的DenseNet、Transformer等模型都受到了其“短路连接”思想的启发。

总结

| =特性 | =描述 |

|---|---|

| 核心问题 | 解决深度神经网络中的“网络退化”问题,而非仅仅是梯度消失。 |

| 核心思想 | 让网络学习残差函数 ( F( x ) = H( x ) - x ),而非直接学习 ( H( x ) )。 |

| 关键机制 | 捷径连接,将输入x直接与卷积层输出相加。 |

| 基本单元 | 残差块,由卷积层和一条捷径连接构成。 |

| 主要优势 | 极大地缓解了梯度消失,简化了学习目标,使训练极深网络成为可能。 |

| 历史地位 | 深度学习发展史上的里程碑,是当今众多模型的基石。 |

希望这个介绍能帮助你透彻地理解残差网络!