DeepSeek大模型本地运行指南:Ollama安装配置与优化技巧

深度求索(DeepSeek),成立于2023年,专注于研究世界领先的通用人工智能底层模型与技术,目前已经研发出DeepSeek V3、DeepSeek R1、DeepSeek Coder等多款大模型。本文介绍DeepSeek相关网站和本机使用Ollama下载运行DeekSeep的方法,并介绍了把Ollama软件安装到其他盘和把模型下载到其他盘的方法,避免占用大量C盘空间。

常用网站

官方网站:https://www.deepseek.com/

开源项目:https://github.com/deepseek-ai/DeepSeek-R1

开放平台:https://platform.deepseek.com/usage

运行方法

我们可以使用Ollama软件本地运行DeekSeep大模型,不需要大显存显卡,使用32G内存即可运行8b以内的大模型,运行速度还能让人接受。

1、下载并安装Ollama。

下载地址:https://ollama.com/

2、在Ollama网站选择要运行的模型。

deepseek-r1模型地址:https://ollama.com/library/deepseek-r1

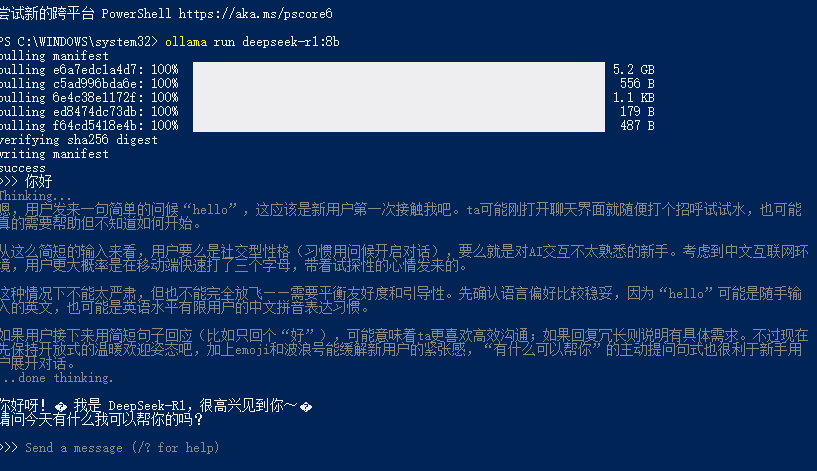

3、打开控制台,执行模型选择页面的命令即可。第一次执行会下载模型,可能需要等待一段时间。

可以安装不同大小的模型,普通用户只建议安装1.5b、7b和8b的模型。

安装并运行1.5b模型,模型大小:1.1GB

ollama run deepseek-r1:1.5b安装并运行7b模型,模型大小:4.7GB

ollama run deepseek-r1:7b安装并运行8b模型,模型大小:4.9GB

ollama run deepseek-r1:8b安装并运行14b模型,模型大小:9.0GB

ollama run deepseek-r1:14b安装并运行32b模型,模型大小:20GB

ollama run deepseek-r1:32b安装并运行70b模型,模型大小:43GB

ollama run deepseek-r1:70b安装并运行601b模型,模型大小:404GB

ollama run deepseek-r1:671b4、等待下载完成,输入文字即可聊天。

5、输入 / 还可以执行命令。

可用命令:

/set 设置会话变量

/show 显示模型信息

/load <模型> 加载会话或模型

/save <模型> 保存当前会话

/clear 清除会话上下文

/bye 退出程序

/?, /help 获取命令帮助

/? shortcuts 查看快捷键帮助

使用三引号 """ 开始多行消息输入。用户界面

1、可以使用Ollama自带的用户界面进行聊天,如图。

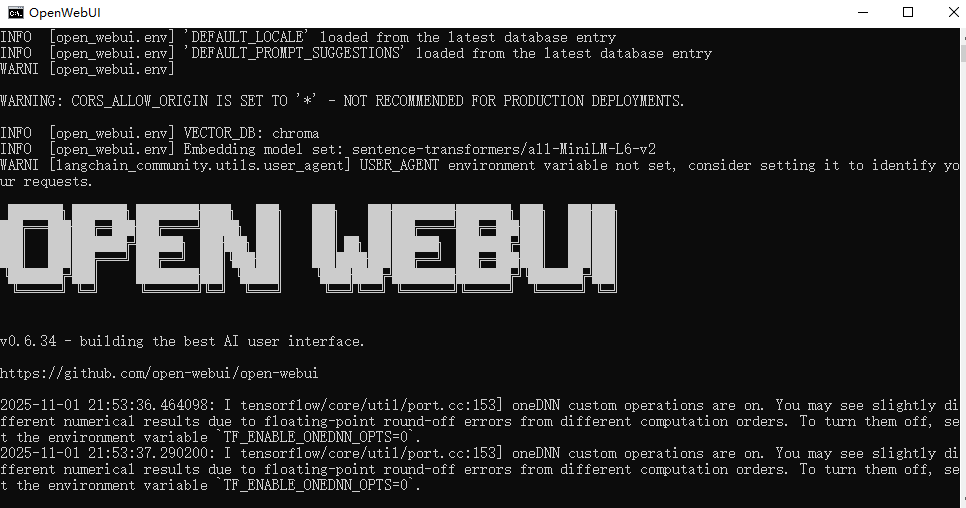

2、如果想要更多功能,例如保存聊天记录、续写等,可以安装使用OpenWebUI。

OpenWebUI官方网站:https://openwebui.com/

OpenWebUI相关文档:https://docs.openwebui.com/

安装方法:需要提前安装好Python,然后执行以下命令即可安装OpenWebUI。

pip install OpenWebUI使用方法:可以在windows上创建一个cmd脚本,双击即可运行。等OpenWebUI启动完成,在浏览器中打开http://localhost:8080即可

@echo off

@chcp 65001

title OpenWebUI

open-webui serve

start chrome.exe http://localhost:8080

pause软件截图:这是OpenWebUI启动和在浏览器中运行的截图。

常见问题

~ 1、如何将Ollama安装到其他盘?

Ollama默认安装在C盘,想要安装到其他盘,例如E:\temp\Ollama,可以在安装包OllamaSetup.exe所在目录按住Shift点击鼠标右键,选择在此处打开Powershell窗口,执行以下命令即可。

.\OllamaSetup.exe /DIR=E:\temp\Ollama2、如果将模型下载到其他盘?

添加环境变量OLLAMA_MODELS,值为模型所在文件夹,例如:E:\temp\ollama\models。重启Ollama即可。